Roboter lernen Empathie

audEERING und Hanson Robotics entwickeln Roboter mit höchster sozialer Kompetenz für den täglichen Einsatz. Einer der weltweit führenden Roboterhersteller Hanson Robotics integriert die automatisierte Emotionserkennung devAIce des deutschen KI-Unternehmens audEERING. Ein Höchstmaß an Mensch-Maschine-Interaktion eröffnet neue Chancen für den Einsatz von Robotern in der Arbeitswelt, zum Beispiel in der Pflege. Roboter erkennen die Emotionen ihres Gegenübers an der Stimme und steigern so ihre soziale Kompetenz.

devAIce® SDK 3.6.1 Aktualisierung

Das devAIce® Team ist stolz darauf, die Verfügbarkeit von devAIce SDK 3.6.1 bekannt zu geben, das seit der letzten öffentlich angekündigten Version 3.4.0 eine Reihe von wichtigen Erweiterungen, spannenden neuen Funktionen und kleineren Korrekturen enthält. Dieser Blogbeitrag fasst die wichtigsten Änderungen zusammen, die seither im devAIce® SDK eingeführt wurden.

SHIFT - Projekt zur Umgestaltung des kulturellen Erbes startet im Rahmen von Horizont Europa

SHIFT: MetamorphoSis of cultural Heritage Into augmented hypermedia assets For enhanced accessibiliTy and inclusion (Umwandlung von Kulturerbe in erweiterte Hypermedia-Assets für verbesserte Zugänglichkeit und Inklusion) unterstützt die Annahme von Strategien für die digitale Transformation und die Einführung von Werkzeugen in der Kreativ- und Kulturindustrie (CCI), in der die Fortschritte bisher nur langsam vorankamen.

audEERING beteiligt sich jetzt am SHIFT-Projekt mit dem Ziel, emotionale Sprachbeschreibungen historischer Exponate zu synthetisieren. Dies wird die Art und Weise, wie man ein historisches Denkmal erlebt, verändern, insbesondere für sehbehinderte Menschen.

Affektive Avatare und die Voice AI-Lösung

Wir verwenden Avatare, um unsere Identität zu zeigen oder andere Identitäten anzunehmen, und wollen sicherstellen, dass wir uns so ausdrücken, wie wir wollen. Der Schlüsselfaktor für den Ausdruck sind Emotionen. Ohne das Erkennen von Emotionen haben wir keine Möglichkeit, den Avatar eines Spielers so zu verändern, dass er seinen Ausdruck und seine Individualität zum Ausdruck bringt.

Mit entertAIn play wird das Erkennen von Emotionen möglich.

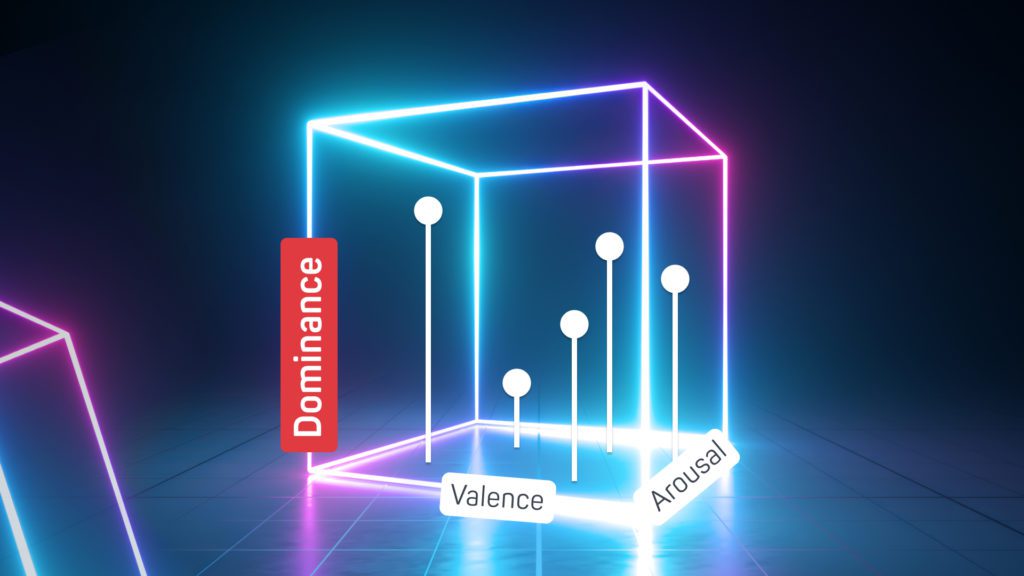

Schließen der Valenzlücke bei der Erkennung von Emotionen

2021 war ein spannendes Jahr für unsere Forscher, die sich mit der Erkennung von Emotionen aus Sprache beschäftigen. Dank der jüngsten Fortschritte bei transformatorbasierten Architekturen haben wir zum ersten Mal Modelle entwickelt, die die Valenz mit ähnlich hoher Genauigkeit vorhersagen wie die Erregung.

Neue Updates für audEERINGs Kerntechnologie: devAIce SDK/Web API 3.4.0

Wir sind stolz darauf, mit der neuesten Version 3.4.0 des devAIce TM SDK/Web API eine neue Klasse von Emotionsmodellen der nächsten Generation für devAIce ankündigen zu können.

ERIK - Emotionserkennung für die Autismus-Therapie

Das Erkennen und Wahrnehmen von Gefühlsäußerungen ist ein wesentlicher Bestandteil der menschlichen Kommunikation. Um die sozio-emotionalen Kommunikationsfähigkeiten autistischer Kinder zu entwickeln, muss die Therapie darauf ausgerichtet sein. Im Rahmen des ERIK-Projekts wird eine neue Form der Therapie entwickelt.

SEMULIN: Audio-KI für autonome Autos

Der Markt für autonomes Fahren wird voraussichtlich von 5,7 Milliarden im Jahr 2018 auf 60 Milliarden US-Dollar im Jahr 2030 wachsen. Dies zeigt das Potenzial, das diese Technologie in Zukunft haben wird, und ist einer der Gründe, warum die deutsche Regierung das Projekt SEMULIN gefördert hat.

Emotionen in Ihr Spiel integrieren

Wenn Sie unsere Blogbeiträge verfolgt haben, wissen Sie, dass wir die Bedeutung von Emotionen und ihre Rolle in unseren täglichen Interaktionen erläutert haben (Link zum ersten Blog). Dann haben wir uns mit der Mensch-Computer-Interaktion im Kontext von Videospielen beschäftigt (Link zum zweiten Blogbeitrag), und schließlich haben wir erklärt, wie Emotionen die fehlende Ebene für die Mensch-Computer-Interaktion sein können (Link zum dritten Blogbeitrag). In dieser Woche werden wir uns ansehen, wie die Integration dieser emotionalen Ebene in Ihre Produkte Ihnen zugute kommen kann und somit die Welt zu einem besseren Ort macht.

Emotionale Interaktion - das fehlende Glied

In unseren letzten Blog-Beiträgen haben wir die Rolle von Emotionen in Videospielen erläutert, einen Überblick über die Mensch-Computer-Interaktion gegeben und was dies für die Videospielindustrie bedeutet. Wir haben herausgefunden, dass wir aus technischer Sicht fast völlige Freiheit in der 3D-Umgebung erreicht haben. In CAVEs kann man sich zum Beispiel in einer virtuellen Umgebung in Echtzeit frei bewegen.

Was AI zu sagen hat: Game of Thrones: Schlacht um Winterfell

Ich denke, Sie können sich vorstellen, was dann geschah. Wir brachten Mikrofone im Konferenzraum an und zeichneten das Publikum während der gesamten Vorführung auf. Dann übergaben wir die erfassten Daten an ExamAIner, eine Webanwendung, die im Backend die Emotionserkennungstechnologie audEERING nutzt.