Die Bäume begannen im Frühjahr 2016 zu blühen, als Oculus Rift als Verbraucherprodukt veröffentlicht wurde. Man konnte es aufsetzen und sich einfach in die virtuelle Welt teleportieren. Seitdem wurde sie mit immer mehr Funktionen ausgestattet, die den Nutzern helfen, noch mehr in die Umgebung einzutauchen.

Sie können Touch Bundles verwenden, um mit der Umwelt zu interagieren, haptisches Feedback wird jeden Monat weiterentwickelt und neue Gadgets helfen uns, mit mehr Sinnen zu interagieren.

Interaktion ist der Schlüssel in virtuellen Umgebungen

Einer der grundlegenden Faktoren, um eine höhere Präsenz und Immersion in virtuellen Umgebungen zu erreichen, ist die Interaktion. Je höher die Reaktionsfähigkeit der Umgebung ist, desto stärker ist das Gefühl der Präsenz in dieser Umgebung.

Zu diesem Zweck haben die Wissenschaftler seit der Einführung der virtuellen Realität versucht, mehr Sinne einzubeziehen. Die meisten dieser Bemühungen konzentrierten sich jedoch auf die Ausgabe des Systems und die Eingabe für den Benutzer. Bessere Bildqualität, 3D-Audio und haptische Westen und Handschuhe.

Affective Computing als Input für die virtuelle Realität

In diesem Artikel möchten wir auf einen weniger erforschten Bereich hinweisen: Affective Computing als Input für die virtuelle Realität.

Also gut, lassen Sie uns die einfache Oma-Version für Nicht-Experten erklären. Mit anderen Worten, wir werden Folgendes tun:

Enkelsohn! Beispiele bitte: Ok, ok, entschuldige Oma. Also, du setzt diese Brille auf (er setzt die Oculus Rift vorsichtig auf Oma auf). Jetzt kannst du im Wald spazieren gehen.

Sie sieht sich um und beginnt, die Avatar-ähnliche Umgebung zu erkunden. Einige Kreaturen beginnen sich vorsichtig an sie heranzupirschen.

Sie findet es heraus und sieht sie sich an. Sie ist begeistert von ihrer süßen, leuchtenden Haut.

Ihre Erregung wird durch ihre Stimme erkannt, und der KI-Prozess zeigt an, dass der Benutzer ein höheres Maß an Erregung erlebt. Diese Informationen werden in das Spiel übertragen.

Als die kleinen niedlichen Glühwürmchen merken, dass sie sich freut, sie zu sehen, und nicht ängstlich oder bedrohlich ist, kommen sie näher. Während sie langsam aus dem Gebüsch krabbeln, wird Oma immer aufgeregter, sich ihnen zu nähern. Diese Aufregung wirkt sich positiv auf die Rückkopplungsschleife aus, und schließlich kann sie sie berühren und streicheln, so wie sie auch ihre eigene Katze streichelt, die gerade aus dem Fenster schaut.

Emotionen sind unsere tiefste Kommunikationsebene

Sie hat sich noch nie so sehr in eine virtuelle Umgebung eingetaucht gefühlt wie jetzt. Warum? Sie konnte sie nicht nur sehen, sondern war auch mit ihnen emotional verbunden. Das ist die tiefste Ebene der Verbindung, die wir herstellen können.

Die Minuten vergehen und ich beobachte immer noch meine Oma, die mitten im Esszimmer sitzt, die Luft um sich herum streichelt und süße Worte sagt.

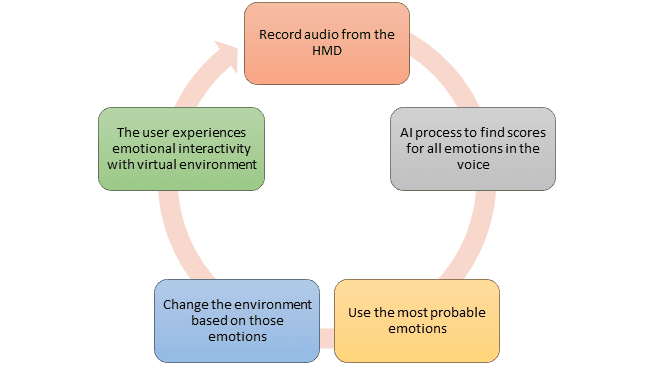

Die technische Seite: Was läuft im Hintergrund ab?

Dieses Maß an Verbindung und Interaktion ist stark genug, um nicht nur eine Großmutter, sondern auch jeden VR-Geek da draußen zu begeistern. Apropos Freak, lassen Sie uns ein wenig technisch werden und sehen, was hier passiert:

Die virtuelle Umgebung ist eine Spielumgebung, die mit Unity oder einer anderen Spiel-Engine erstellt wurde. Die Ausgabe wird einfach auf Oculus Rift portiert, so dass der Benutzer die visuelle Ausgabe in der ersten Person erleben kann. Die In-Ear-Kopfhörer mit Geräuschunterdrückung (z. B. Jabra Elite) helfen ihr, die Atmosphäre des Waldes und jedes kleine Geräusch zu hören, das diese niedlichen Kreaturen machen. Sie können auch die Stimme der Großmutter aufnehmen und über Bluetooth an den PC übertragen. Die Stimme wird mit einem Unity-Plugin zur Emotionserkennung verarbeitet. Die Ausgabe dieses Plugins ist ein JSON-Objekt mit Bewertungen und deren Wahrscheinlichkeit für alle Emotionen, die wir erleben können.

Eine if-Anweisung schließlich prüft und ändert die Umgebung auf der Grundlage der eingegebenen Emotionen.

Dies ist weder ein Traum noch ein Science-Fiction-Film. Es ist einfach der aktuelle Stand der verfügbaren Technologien. Mit Audiotechnik und maschinellem Lernen und den Werkzeugen, die wir der Community zur Verfügung gestellt haben, ist es heutzutage absolut möglich.

Die Stimme transportiert viel mehr als nur das, was wir sagen

Wir vergessen meist, wie viele Informationen unsere Stimme transportiert. Jeder Satz, den wir sagen, und jeder Ton, den wir erzeugen, ist das Ergebnis dessen, was wir innerlich erleben. Wir können Emotionen erkennen und sie für viele gute Zwecke nutzen.

Die Verbindung durch Gefühle ist fast so alt wie die menschliche Evolution selbst. Sie ist in unserem Gehirn verankert und wird sich auch nicht ändern. Die Extraktion der Stimme ist nicht invasiv und natürlich, und die Ergebnisse und die Genauigkeit der Emotionserkennung sind akzeptabel genug, um in Verbraucherprodukten verwendet zu werden.

Zu guter Letzt, wenn Sie wie wir ein Träumer sind und davon geträumt haben, in eine Umgebung einzutauchen, die auf unsere Emotionen reagiert, nehmen Sie Kontakt mit uns auf und lassen Sie uns Ihnen helfen, diesen Traum zu verwirklichen.